Auf dem Search On 22-Turnier in diesem Moment kündigte Google eine Auflösung der neuesten Komponenten in einer unbestimmten Zeit in der Zukunft von Google Search, Google News, Google Wanting und Vergangenheit an. Lassen Sie uns über eine der kritischsten Komponenten kämpfen, über die Google in diesem Moment gesprochen hat.

Eines zu verbergen: Nicht mehr wie die Search On-Events, die wir in der Vergangenheit hatten, schien es, als ob dieses Turnier zentrierter war über möglicherweise kleinere Komponenten im Vergleich zu Google, das einen großen Durchbruch bei der Suche verkündet. Äquivalent zu den früheren Ankündigungen mit BERT, MUM und völlig anderen KI-im Wesentlichen basierenden, größtenteils vollständig verbesserten Fortschritten in der Google-Suche.

Inhalt

1. Multisearch expandiert

Google weitet Multisearch in den Ankunftsmonaten auf 70 neue Sprachen aus. Google startete Multisearch in den letzten 300 und 65 Tagen für Englisch und US-basierende Suchanfragen.

Was ist Google Multisearch.

Google Multisearch ermöglicht es Ihnen, das Handy Ihrer Kamera zu verwenden, um nach einer Aufzeichnung zu suchen, die von Google Lens unterstützt wird, und dann eine weitere Textnachricht über die Bildsuche hinzuzufügen. Google verwendet dann sowohl das Bild als auch den Text, um die für Sie sichtbaren Suchergebnisse zu verbergen.

So funktioniert die Google-Mehrfachsuche. Öffnen Sie die Google-App auf Android oder iOS, klicken Sie auf das Google Lens-Digicam-Symbol auf der hübschen Seite des Suchfelds. Dann richten Sie die Kamera auf etwas in der Nähe oder verwenden Sie eine Aufnahme in Ihrer Kamera und machen Sie sogar eine Aufnahme von einer Sache in Ihrem Versteck. Dann wischen Sie auf jeden Fall auf den Ergebnissen nach oben, um sie aufzurufen, und tippen Sie auf die Schaltfläche „+ Zu Ihrer Suche hinzufügen“. In diesem Feld können Sie Textanweisungen zu Ihrer Anfrage hinzufügen.

Dass Sie hier mehr über diese Option erfahren können.

2. Multisearch endet für mich bald

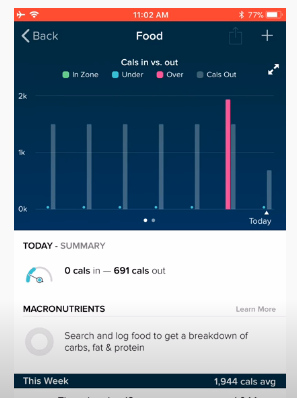

Nach 300 und 65 Tagen endet Google Multisearch für mich bei Google I/O. Intelligenterweise wird Google diese Funktion in den englischen und US-amerikanischen Suchergebnissen in den Ankunftsmonaten einführen. Google sagte technisch, dass dies voraussichtlich im Spätherbst 2022 möglich sein wird.

Was für mich Multisearch ist Mit der Funktion zum Beenden von mir können Sie diese Bild- und Textanfragen vergrößern, indem Sie Produkte oder etwas anderes mit Ihrer Kamera kaufen, aber auch native Ergebnisse retten. Wenn Sie es also bewundern, ein Restaurant mit einem Zuggericht retten zu wollen, könnten Sie es erfinden.

3. Google Lens übersetzte Textanweisungen jetzt sauberer

Google Lens macht so viel Spaß und ermöglicht es Ihnen, Ihre Kamera in nahezu jeder Umgebung auf Textanweisungen zu richten, um diese Textanweisungen zu übersetzen. Jetzt wird Google Lens beweisen, dass übersetzte Textanweisungen in einer saubereren und gemischteren Form vorliegen. Here’s launch später in diesen 300 und 65 Tagen.

Google nutzt Generative Adversarial Networks, auch GAN-Gadgets genannt, um die übersetzten Textanweisungen besser zu beweisen. Die identische Technologie, die Google in den Pixel-Gadgets wie die „Magix Eraser“-Funktion für Bilder verwendet, ist weit entfernt.

Hier ist ein Beispiel, das zeigt, wie Google Lens die Interpretation auf viel weniger komplizierte Weise abdeckt Ansatz für Suchende zu verstehen:

4. Google iOS App-Verknüpfungen

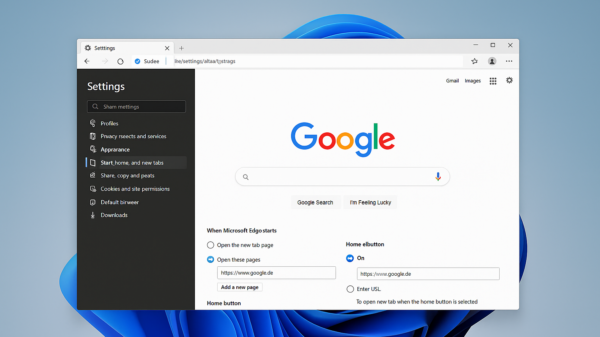

Heute wird die Google-Suche-App für iOS Verknüpfungen hinzufügen, um es den Suchenden einfacher zu machen, zu suchen, zu übersetzen, Streitsuchen zu verwenden, zu übersetzen, Screenshots hochzuladen und vieles mehr mehr. Hier ist ein Screenshot einiger dieser Abkürzungen im Rennen:

Während dies gerade in diesem Moment in den USA für iOS-Benutzer auf den Markt kommt, ist dies vermutlich auch in der Lage, später in diesen 300 und 65 Tagen auf Android zu kommen.

5. Neue Suchverfeinerungen

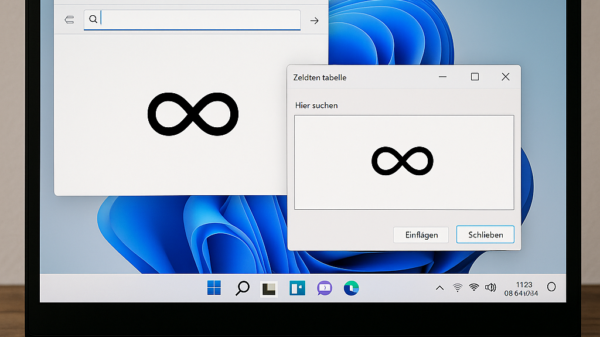

Google führt auch neue Suchverfeinerungen und -hilfen für den Fall ein, dass Sie in der automatischen Vervollständigung und in den Suchergebnissen suchen. Jetzt, während Sie Ihre Anfrage eingeben, zeigt Google tippbare Wörter, um Ihre Anfrage im Handumdrehen zu erstellen. Hier ist ein Löschen einer Anfrage des Bauherrn, indem man einfach auf Wörter tippt.

Hier ist ein GIF davon im Rennen:

Außerdem werden Sie umfangreichere Aufzeichnungen ausspionieren, die in den Ergebnissen der automatischen Vervollständigung verborgen sind, während Sie suchen.

Google hat auch die Möglichkeit, Ihre Suche nach der Suche zu verfeinern, indem Sie Themen hinzufügen oder entfernen können, die Sie bewundern, um hinein- oder herauszuzoomen. Es hilft Ihnen, herauszufinden, wofür Sie wahrscheinlich kaufen, indem es die Kopfsuchleiste so anpasst, dass sie dynamischer gesteuert wird.

Hier ist ein Screenshot dieser oberen Leiste mit Verfeinerungen:

6. Extra sichtbare Datensätze

Google zeigt für einige Suchanfragen eine optisch ansprechendere Formel zu den Suchergebnissen an. Auf diese Weise können Sie mehr Aufzeichnungen zu Themen wie Joggen, Menschen, Tiere, Vegetation usw. durchsuchen.

Google verbirgt Ihnen sichtbare Geschichten, schnelle Videos, Hinweise, zu erfindende Themen und mehr, wenn Sie darauf rechnen erkundigen. Google könnte vermutlich auch die relevanteren Datensätze zu dieser UX visuell hervorheben.

7. Beim Scrollen erkennen

Wenn Sie durch die Google-Suchergebnisse scrollen, gilt: Je weiter Sie scrollen, desto weniger relevant sind die Ergebnisse. Ich meine, das macht Sinn, Google muss im Wesentlichen die relevantesten Datensätze an der Spitze platzieren.

Also hat Google eine brandneue Suchfunktion hinzugefügt, um den Suchenden Inspiration für ihre Suche zu geben, aber nicht mehr etwas, das genau zu ihrer Suche passt.

Sucher können diese neue Erkundungsfunktion verwenden, um Themen über ihre Lieblingssuche hinaus zu studieren.

Hier ist der Start für englische und US-Ergebnisse in den Ankunftsmonaten.