„Explore and Focus on“ für den Nest Hub Max, der auf der I/O 2022 vorgestellt wurde, und Google hat nun detailliert beschrieben, wie genau die im Wesentlichen auf Digicam basierende „Hey Google“-Alternative funktioniert.

Google nennt „Explore and Focus on“ – was nach Zoolander den furchtbar amüsanten Codenamen „Blue Steel“ trägt – die „erste multimodale, maschineninterne Assistenteneigenschaft, die gleichzeitig Audio, Video und Text, um zu entscheiden, ob Sie mit Ihrem Nest Hub Max sprechen.“

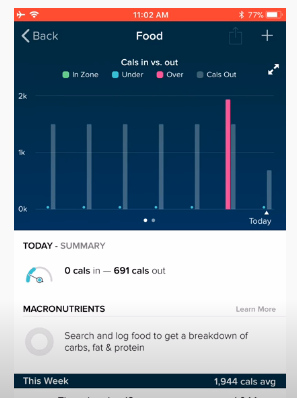

Jede Interaktion besteht aus drei Verarbeitungsphasen, wobei der Assistent einen Blick auf die Indikatoren für Nähe, Gesichtserkennung und Kopfausrichtung wirft , Leer Direction, Lip Movement, Articulate Match, Contextual Consciousness und Intent Classification. Es gibt über 100 Signale von der Kamera und dem Mikrofon insgesamt, wobei die Verarbeitung in der Nähe des Computers ausfällt.

Im Allgemeinen tut es ein gutes, umfassendes Interplay-Signal treten jetzt erst effektiv auf, nachdem der Benutzer begonnen hat zu sprechen, was bereit ist, sodass Sie eine ganze Reihe von Millisekunden Latenzzeit hinzufügen können, und vorhandene Objekte für die Absichtsvorstellung kommen hinzu, da sie vollständige, jetzt nicht partielle Abfragen erfordern. Um diese Lücke zu schließen, verzichtet Explore and Focus vollständig auf das Streamen von Audio zum Server, wobei die Transkription und der Absichtsbegriff auf dem Computer vorhanden sind.

Es beginnt mit dem Nest Hub Max bestimmt, ob ein „Benutzer die Absicht zeigt, mit ihm zu interagieren .“ Sie müssen 5 Fuß groß sein und von Face Match erkannt werden, wobei Google darauf achtet, flüchtige Blicke auf die Maschine zu ignorieren.

Für einen registrierten Benutzer mit internem Unterschied bestimmt eine benutzerdefinierte Schaufensterpuppe, ob sie einen Blick auf den Entwickler werfen